140天还是一千多年

【中关村在线原创】前不久,Deepmind团队再次在《自然》杂志发表论文,论文表示,从0开始,完全无需输入人类下过的棋谱,也可以在很短的时间让围棋软件棋力超过以往,这个时间是40天。很多人不禁要问:是不是我也可以在家训练围棋或是其它人工智能了?答案显然是不行。

没有超级计算机,难玩人工智能

40天就可以这么强

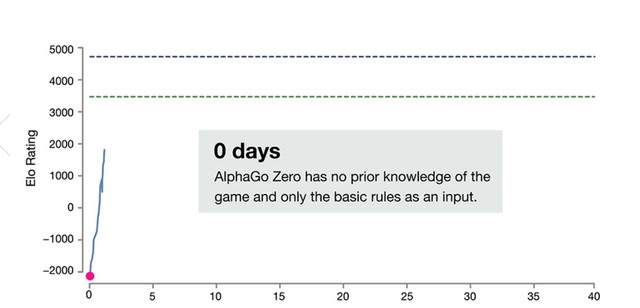

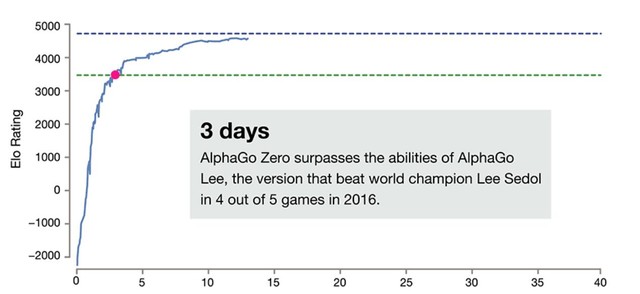

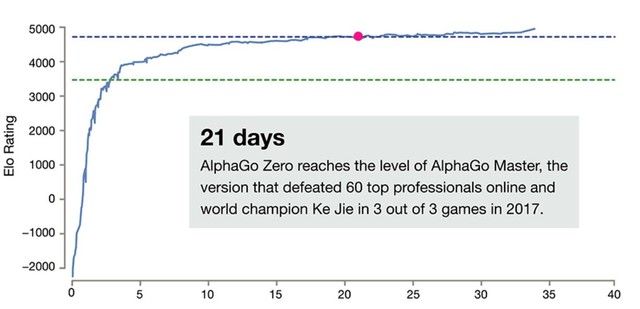

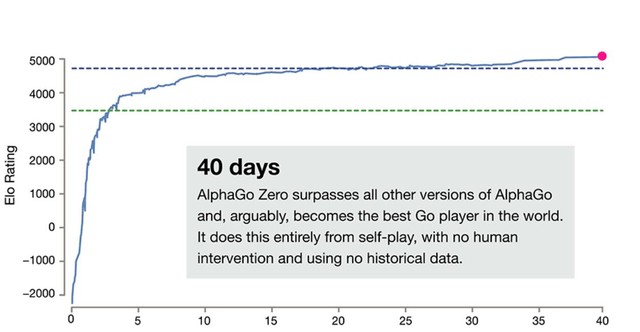

我们先来看看Deepmind的训练成果。Deepmind完全不输入棋谱,只是输入规则(这个规则和我们人类的还有点区别,但是结果的导向一样),只训练了3天,就可以下赢去年对弈李世石的AlphaGo版本,21天赢今年和柯洁对弈的Master版本,40天的时候棋力达到了史无前例的Elo评估分5200(人类最强柯洁是3600多).

Deepmind这是一篇学术论文发表在《自然》杂志上,学术论文的意义在于可重复性。在第一篇论文之前,计算机围棋程序只能和业余4段掰下手腕,而和李世石的对弈整门了可以赢职业九段!在论文指导下,腾讯的绝艺,日本的Deepzen Go、台湾的CGI等程序迅速崛起,也达到了可以和职业九段互有输赢的水平,这是一场大跃进。

那么是不是我有计算机水平、懂机器学习,也可以训练一个超强的围棋程序呢?答案是不行。因为你玩不起硬件,这是个属于大公司的烧钱行为。

2它的40天你的一千年

它的40天你的一千年

论文发表之后,很多人也想自己训练。在论文里面,Deepmind没有详细的指出自己训练的规模有多大,但是停止在40天可见并不是一个省钱的营生。论文里面说的是训练使用了64个GPU Server。

机器学习要GPU

要注意,机器学习、神经网络这个事情,单独堆传统的CPU效率不高,必须要运算核足够多的GPU,越多越好。所以Deepmind可以依靠谷歌调动大量的计算资源,我们是比不了的。

于是有人算了一下,这个人不是别人,是台湾围棋程序CGI的作者,吴毅成教授。他的CGI和AlphaGo类似,他给出了估算,那就是如果你只有一块顶级游戏卡nVidia GTX1080ti,用这个卡训练,需要1200多年!

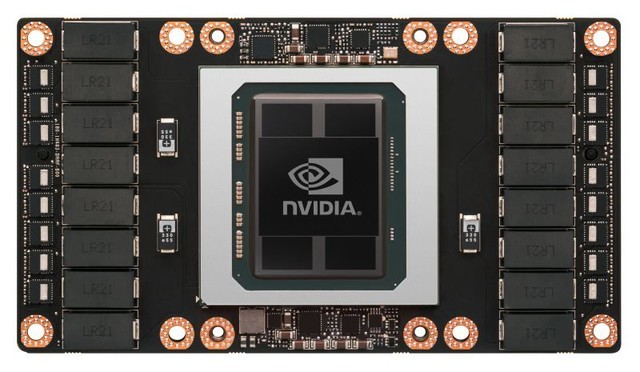

那么反过来,Deepmind没有细说的64GPU训练服务器,就不是普通的单服务器,而应该是64个GPU服务器群,可能是上面这样的。

3人工智能变成了资源战争

人工智能变成了资源战争

对于一般的研究机构,也想玩玩人工智能,一样起步价非常高。比如英伟达官方给提供的8GPU服务器DGX-1,有8个GPU,这机器电商上可以买到的价格是100多万元,而且每年的服务费还要一笔钱。

英伟达官方的DGX-1有8个GPU,要一百多万人民币

当然也有DIY的,双志强E5+可选GPU数量,让配置更有弹性。但是问题在于,如果游戏卡,训练的效果稍差,但是相对便宜;而如果用专门的Tesla GPU则每一个都不便宜,这种8个GPU的机器一般来说也就只能搞搞小的研究。

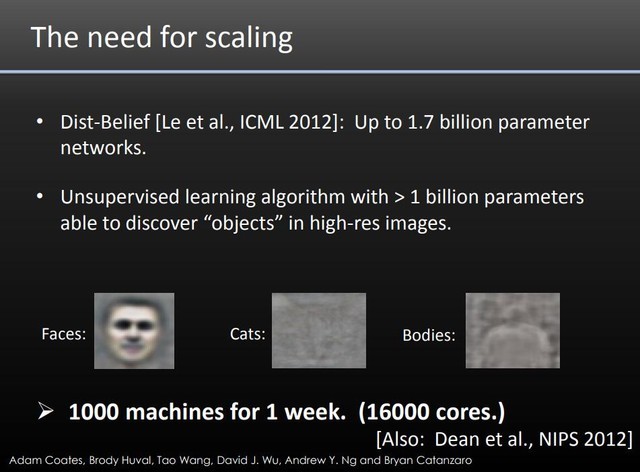

2012年的时候用了1000个服务器,16000个CPU核心训练了一周

比较大的规模,比如让机器学习如何识别图片里的马克杯,要调用的资源就很多,这个资源要求来自几年前百度分享的PPT。谷歌大脑搞机器识别图片据说调用了上万个GPU。

4能源、AI与挖矿

能源、AI与挖矿

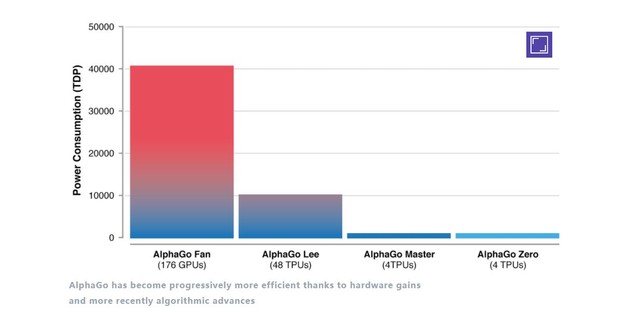

下面的图片是不同版本的AlphaGo对于电力的要求,可以看到最早和李世石下棋的版本,就是上面图片的这个大机架,居然电力要求是40千瓦,而只有176个GPU。那么对于动辄几千上万的GPU,电力的要求同样是个大问题。

176个GPU就要40千瓦的电力供应

人工智能的好处是训练很费力,但是训练好的程序却不大,因为人不知道里面的结果代表的意义,这是有意思的地方。不过最近这几年GPU一直缺货、涨价,可不全是因为AI,而是国内很多买去做矿机挖比特币。

可以这么说,除非您有足够的天赋,能够从算法层面突破,否则必须要依靠有足够资源的研究机构,比如有足够好的选题,可以使用配置了几千个GPU的天河-1A超级计算机、自己就有成千上万GPU的大公司才能去搞复杂问题的人工智能。

想单枪匹马就搞定复杂问题,进行AI训练,已经不现实了。40天还是一千年,硬件的鸿沟无法逾越。