���йش�����ԭ����ǰ�������㽭��Χ��ĿǰELO�ȼ��ֵ�һ���������ھ��½���Deepmind���˹�����Χ�����AlphaGo���������������Ļ�������������ǿ����˿½����ˮ���ڶ����˻���ս��ȫ�����ʶ���˽����AI��Խ�㷨������������˫�غ���֮�£�������������༸ǧ�������۵�Χ��������뾭�顣���ź����ǣ�DeepMind����AlphaGo��ɽ�ˣ�����ֻ����һ�δ��档

�й���Ժ����AlphaGo��43����ʽ�Ŷ�֤��

AlphaGo�ļ�����������

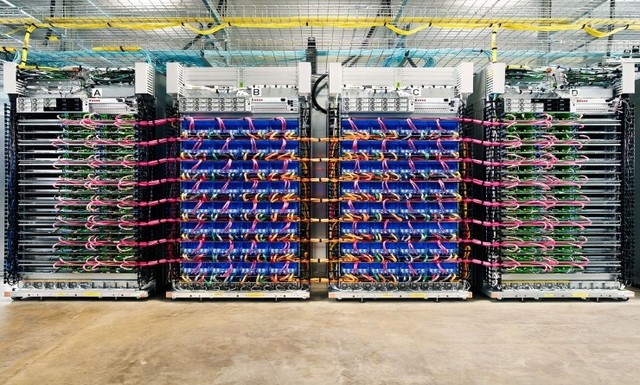

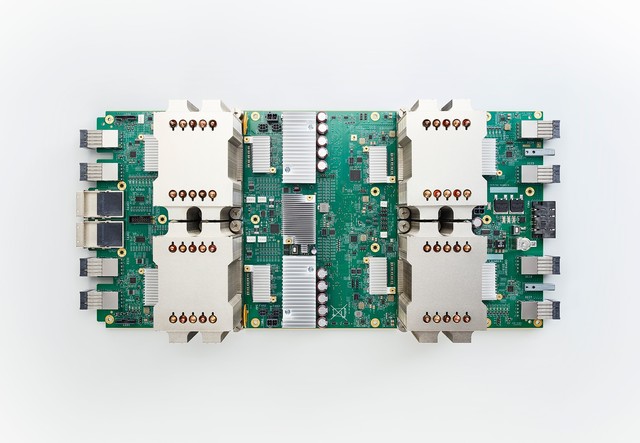

����˻���ս���ڶ����AI��̳���Ϻܶ࣬��ϧ������ߵ����ʶ�û����Deepmind AlphaGo����ϯDavid Silver�������AlphaGo�ļ���ϸ�ڡ�������֪����˵������ʯ�汾����Ҫ1300�������������280��GPU������汾�Ľ��ˣ�����ֻҪ4��TPU�Ϳ��ԣ����Ժ������������ף�Ӧ���Dz����˺ܶ��AlphaGoһ���µģ��������Լ�����ռ������ټƵĹ����������ס�

TPU2�������ÿ��Կ���TPU��CPU��Լ����2:1�ı���

AlphaGo��Ӳ���ܹ�����ȵ�������������ȴ�������������Ϊ�Ƽ�����ļ��ߣ�������������ǣ����������㷨��������Ҫ���ټ����������ܴﵽMaster��������������ƴ���ǡ���Ԫ���ڵ������������CPU�ж�죬һ����˵����TPU��CPU=2:1��Ҳ����˵���һ��˫����������ǿE5 2699�����ڴ棬����4��TPU�������������㣬ʵ���õ�һ�����Ϳ���ʵ����ѹ���������������

������ǿ����ѧϰ���ٿ���nVidia��TESLA P100

�ٻ���һ�£���Ϊ������TPU�����ǹȸ��ڲ�ʹ�õġ������ܲ����ϣ�TPU2�ļ���������45TFLOPS���ĸ�����180T����NV�ոչ�������DGX-1��8��Tesla P100����170T�������������϶����൱��Ҳ�����ձ���DeepZenGo�����ã�˫��ǿ2699V4+4 GTX1080��ʵҲ���ˣ�ֻ�ǡ��������㷨���湷��̫�ࡣ

����֮��ʵ���ϵ�AlphaGo��һ��TPU4������˿���ֻҪ4��Tesla P100���ܾ��Ѿ��߱������Ӧ�ļ�������Google�Լ���TPU����Ϊ�Լ���TensorFlow�Ż������б��⻨̫��Ǯ��GPU����˼�������Ƶ�TPU��������ѧϰ��Ч�ʸ��ߡ�

��������ԭ�����£�����ת�أ���ע����Դ��һ������������ɣ�AlphaGo��Χ����//oa.zol.com.cn/642/6422051.html

�Ƽ�������